一张图了解机器学习

机器学习是人工智能(AI)的一种应用,为系统提供无需明确编程就能根据经验自动学习和改进的能力。

机器学习根据不同的任务类型可以分为以下三大类型:

1.有监督学习

2.无监督学习

3.强化学习

有监督学习

监督学习是一种机器学习任务,通过训练学习一个函数,该函数根据示例输入-输出对将输入映射到输出。(需要数据标注,输入->输出)

在这种类型中,机器学习算法是在标记数据上训练的。尽管这种方法需要准确地标记数据,但在适当的情况下使用监督学习是非常有效的。

开始时,系统接收输入数据和输出数据。它的任务是创建适当的规则,将输入映射到输出。训练过程应该持续,直到表现水平足够高为止。

在训练之后,系统应该能够分配一个在训练阶段没有看到的输出对象。在大多数情况下,这个过程是非常快速和准确的。

监督学习的类型:

Regression:回归,输出是连续值

Classification:分类,输出是离散值

回归

回归是一种有监督的机器学习技术,用于预测连续值。例如,我们可以用它来预测某种产品的价格,比如某个城市的房价或股票的价值。

机器学习中的回归由数学方法组成,数据科学家可以根据一个或多个预测变量(x)的值预测一个连续的结果(y)。

线性回归可能是回归分析中最流行的形式,因为它在预测和预测中很容易使用。

分类

分类是一种旨在重现类别分配的技术。它可以预测响应值,并将数据分成“类”。例如识别照片中的汽车类型,鉴别垃圾邮件,检测表情,人脸识别等等。

分类的三种主要类型是:

a)二元分类 Binary Classification

它是分类的过程或任务,其中将给定的数据分为两类。 它基本上是一种关于事物属于两个群体中的哪一个的预测。

假设有两封电子邮件发送给您,一封是由不断发送广告的保险公司发送的,另一封是您的银行发送的关于您的信用卡账单的电子邮件。

电子邮件服务提供商将对两封电子邮件进行分类,第一封将发送到垃圾邮件文件夹,第二封将保留在主邮件中。

这个过程被称为二元分类,因为有两个离散的类,一个是垃圾邮件,另一个不是垃圾邮件的。 所以这是一个二元分类的问题。

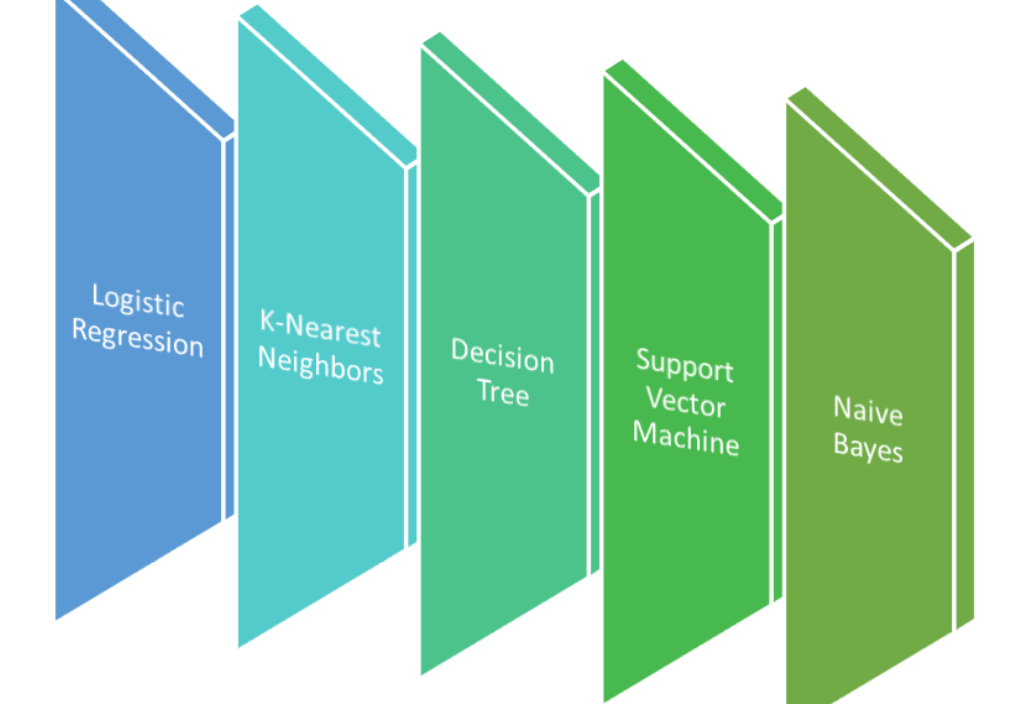

算法:

逻辑回归

KNN

决策树/随机森林/提升树

支持向量机 SVM

朴素贝叶斯

多层感知机

b)多分类 Multi-class Classification

多类分类是指那些具有两个以上类标签,但是输入数据只对应一个类标签的分类任务。

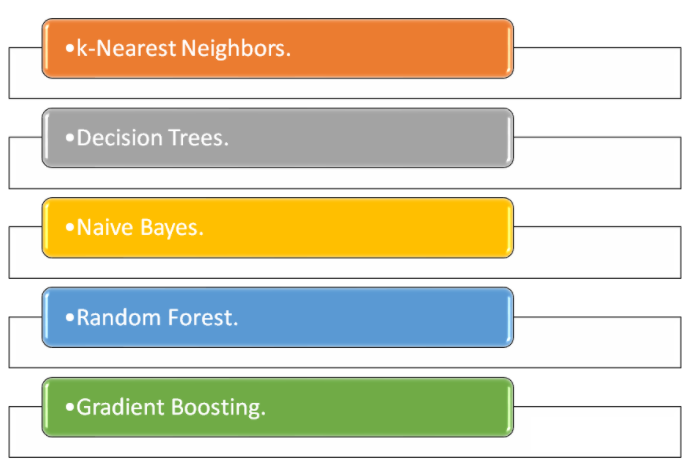

算法:

KNN

决策树/随机森林/提升树

朴素贝叶斯

多层感知机

注:这里去掉了SVM和 逻辑回归,因为他们只支持二分类,但是可以通过其他方法实现多分类,一般情况下会构建与分类数相同的模型并进行二元分类,比如数字识别0-9,svm会训练10个二元模型,分别判断是否是1,是否是2,逻辑回归也是同理。

c)多标签分类 Multi-Label Classification

多标签分类是指那些具有两个或多个类标签的分类任务,其中每个示例可以预测一个或多个类标签。

多分类可以叫做单标签多分类,是一对一的关系,而多标签分类是一对多的关系

通俗的讲,一张照片里面有猫和够,如果使用多分类来说,他只能将照片分成1类,猫或狗(一对一),但是对于多标签来说,会同时输出猫和够(一对多)

无监督学习

无监督学习是指使用人工智能 (AI) 算法来识别包含未标记的数据点的数据集中的模式。在训练时算法对包含在数据集中的数据点进行分类、标记和/或分组,在执行训练时无需任何外部指导。换句话说无监督学习允许系统自行识别数据集中的模式。在无监督学习中,即使没有提供任何的期望输出模型也会根据异同对信息进行分组。

无监督学习算法可以执行比监督学习系统更复杂的处理任务。

无监督学习的类型:

A.聚类

聚类是指自动将具有相似特征的数据点组合在一起并将它们分配给“簇”的过程。

常用算法:

K-Means(K均值)

DBSCAN

使用高斯混合模型(GMM)

B.关联

关联规则学习是一种无监督学习技术,它实在大型数据中检查一个数据项对另一个数据项的依赖性 ,它试图在数据集的变量之间找到一些有趣的关系或关联。根据不同的规则来发现数据中变量之间的有趣关系。

常用算法:

Apriori算法

PCY算法

FP-Tree算法

XFP-Tree算法

GPApriori算法

应用:

市场分析:是关联规则挖掘的流行示例和应用之一。 大型零售商通常使用这种技术来确定商品之间的关联。(啤酒尿布)

医学诊断:关联规则有助于识别特定疾病的患病概率。

蛋白质序列:关联规则有助于确定人工蛋白质的合成。

强化学习

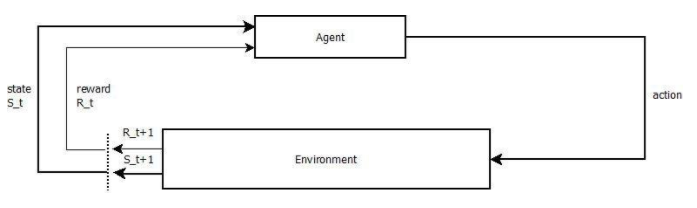

强化学习 (RL) 是一种机器学习技术,它使代理通在交互式环境中通过来自其自身行为和经验的反馈进行学习。

尽管监督学习和强化学习都使用输入和输出之间的映射,但与向代理提供的反馈是执行任务的正确动作集的监督学习不同,强化学习使用奖励和惩罚作为积极和消极行为的信号。

与无监督学习相比,强化学习在目标方面有所不同。 虽然无监督学习的目标是找到数据点之间的异同,但在强化学习的情况下,目标是找到一个合适的动作模型,使代理的总累积奖励最大化。

描述 RL 问题基本要素的一些关键术语是:

环境Environment ——代理运行的物理世界

代理Agent ——也叫智能体,就是我们所写的算法

行动Action——代理产生的动作

状态State——代理的状态

奖励Reward——来自环境的反馈,好的还是坏的

策略Policy ——将代理的状态映射到动作的方法,通过状态选择做什么行动

价值Value ——代理在特定状态下采取行动将获得的未来奖励

deephub译者注

机器学习可以根据不同的分类方法分成不同的类型,例如本文是根据任务类型来进行区分的大类,例如我们常见的,图像分割其实就是对于图片像素级别的分类任务,而目标检测主要的目标就是边框的回归。

对于实现的方法,我们还可以根据模型分成不同的实现方法,例如

传统的机器学习:各种回归

核方法:SVM等

贝叶斯模型:概率相关

树型模型:决策树、随机森林、各种boosting

神经网络:多层感知机、各种NN

以上分类并不冲突并且是交叉的。最简单的就是我们在使用神经网络分类和回归的时候,最后一层一般都会使用线性层(有的也叫稠密层)这一层使用的算法就是线性回归,再例如我们也可以使用神经网络来进行聚类算法,比如deepCluster。

作者:Sachin Sakthi K S

链接:https://www.toutiao.com/article/7023558983197770271/?channel=&source=search_tab&wid=1711410959630

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

声明:海森大数据刊发或者转载此文只是出于传递、分享更多信息之目的,并不意味认同其观点或证实其描述。若有来源标注错误或侵犯了您的合法权益,请作者与本网联系,我们将及时更正、删除,谢谢。电话:152 6451 3609,邮箱:1027830374@qq.com

栏目

相关

时间

2024-03-26 08:05:28

作者

Sachin Sakthi K S